En robots.txt-fil fungerar som riktlinjer för hur sökmotorerna ska navigera på din hemsida när de crawlar den. Inom SEO är robots.txt-filen viktig och kan få stor betydelse i arbetet med att förbättra din hemsidas synlighet i det organiska sökresultatet – men hur fungerar det? Vi tittar närmare på robots.txt och på hur du kan använda filen i ditt SEO-arbete.

Vad är robots.txt?

Robots.txt är en fil som ligger på din hemsida och fungerar som en instruktion till sökmotorerna. I filen kan du ge instruerande direktiv för hur Googlebot och andra sökmotorers crawlers navigerar på din hemsida samt ange vilka sidor och kategorier som ska indexeras – och vilka som inte ska det. Genom att använda robots.txt kan du alltså ta större kontroll över vilket innehåll som syns i sökresultaten och därmed förbättra din sökmotoroptimering.

Så fungerar robots.txt

Vid indexering av en hemsida besöker en crawler webbplatsen och läser av robots.txt-filen. I filen finns instruktioner om vilka sidor som ska indexeras eller förbli oindexerade. När sökmotorn stöter på en sida som inte får indexeras enligt robots.txt hoppar crawlern över den sidan och exkluderar den från sitt index – sidan syns därmed inte i sökresultatet. Observera att filen endast fungerar som riktlinjer och att sökmotorernas crawlers kan välja att bortse från dessa.

Skapa fil

För att skapa en robots.txt-fil behöver du bara skapa upp en textfil (en fil i .txt-format) med namnet “robots.txt” och placera den i rotmappen på din webbplats. I filen kan du sedan ange vilka sidor och kategorier som ska indexeras och vilka som inte ska det. Så här går du till väga:

- Identifiera vilka sidor och kategorier på din webbplats som du vill att sökmotorerna ska indexera. Detta kan inkludera produkt- eller tjänstesidor, blogginlägg samt andra relevanta sidor.

- Använd User-agent-kommandot för att specificera vilka sökmotorer du vill rikta din robots.txt-fil till. Om du vill blockera specifika sökmotorer kan du använda User-agent-kommandot tillsammans med Disallow-kommandot.

- Använd Disallow-kommandot för att blockera sidor eller kategorier som du inte vill att sökmotorerna ska indexera. Tänk på att din SEO kan påverkas negativt om du blockerar för många sidor eller kategorier.

- Använd Allow-kommandot för att tillåta sökmotorerna att indexera specifika sidor eller kategorier som du tidigare har blockerat med Disallow-kommandot. Detta kan vara användbart om du vill inkludera en specifik sida eller kategori trots att du tidigare har blockerat den.

- Inkludera en länk till din sitemap i din robots.txt-fil för att göra det enklare för sökmotorerna att hitta och indexera din webbplats. Du kan använda Sitemap-kommandot för att inkludera länken till din sitemap.

- Testa din robots.txt-fil regelbundet för att se till att den innehåller de rätta instruktionerna för sökmotorerna. Det finns flera verktyg online som kan hjälpa dig att testa din fil och se till att den fungerar som den ska.

- Undvik att skapa en för stor fil. Sökmotorerna har interna gränser för maximal filstorlek. Googles maximala filstorlek är 500 kB.

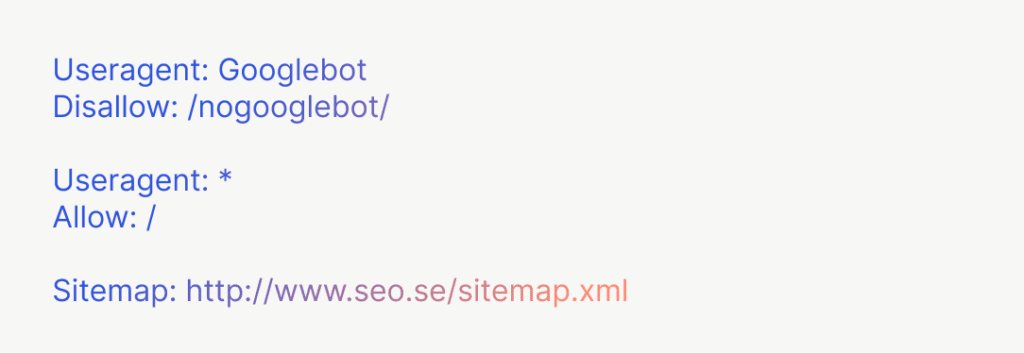

Så här kan din robots.txt-fil se ut:

- User-agent: identifierar vilken crawler som kommandot gäller

- Allow: en URL som du vill ska crawlas

- Disallow: en URL som du inte vill ska crawlas

- Sitemap: den fullständiga URL:en till din sitemap

Skapa med hjälp av WordPress robots.txt

Om du använder WordPress som plattform för din hemsida finns det flera plugins som kan hjälpa dig att skapa och hantera din robots.txt-fil. Ett exempel på ett sådant plugin är “WP Robots Txt“.

Sitemap

En sitemap är en lista över alla sidor på din webbplats som du vill att sökmotorerna ska indexera. Genom att inkludera en sitemap i din robots.txt-fil kan du göra det enklare för sökmotorerna att hitta dina viktigaste sidor och indexera din webbplats.

Robots.txt tester

För att säkerställa att din fil fungerar som den ska är det viktigt att testa den regelbundet med en så kallad Robots.txt tester. Det finns flera verktyg online som kan hjälpa dig att testa din robots.txt-fil och se till att den innehåller de rätta instruktionerna för sökmotorerna. Google har en egen robots.txt tester. Instruktioner för hur du använder det hittar du hos Google. Observera att du behöver ha lagt till din domän i Google Search Console för att kunna använda verktyget.

Blockera specifika sökmotorer

Utöver att blockera vissa sidor kan du också använda robots.txt för att blockera specifika sökmotorer från att indexera din webbplats. Detta kan vara användbart om du exempelvis vill att din webbplats bara ska synas på vissa sökmotorer eller om du har upplevt problem med en viss sökmotor. Du kan använda User-agent-kommandot för att specificera vilka sökmotorer du vill blockera. Tänk dock på att det finns vissa sökmotorer som inte följer instruktionerna i robots.txt-filen.

Sökmotorer som ignorerar hela eller delar av filen

Det finns vissa sökmotorer som inte nödvändigtvis följer robots.txt-filen eller som kan ignorera vissa av dess instruktioner. Här är de mest kända:

- Yandex (rysk sökmotor)

- Baidu (kinesisk sökmotor)

- Bingbot (Bings sökrobot)

- Googlebot-Image (Googles bot för att indexera bilder)

Använd avancerade instruktioner

Förutom att blockera sidor och sökmotorer kan du också använda robots.txt för att ge mer avancerade instruktioner till sökmotorerna. Du kan exempelvis ange hur ofta sökmotorerna ska besöka din webbplats eller hur lång tid de ska vänta innan de indexerar en sida efter att den har uppdaterats. Du kan också använda Wildcard-kommandot för att blockera en hel kategori av sidor istället för att lista dem en efter en.

Robots.txt wildcard-kommandon

- * anger 0 eller fler instanser av valfritt giltigt tecken

- $ anger slutet av URL:en (slugen)

Tänk på detta

Ta hänsyn till “crawl budget”

Sökrobotarna har en begränsad “crawl budget”, det vill säga en begränsad mängd tid och resurser som de kan använda för att indexera din hemsida. Genom att använda robots.txt kan du guida sökmotorerna till att spendera sina resurser på de sidor som är viktigast för dig. Tänk på att ju fler sidor du blockerar, desto mindre resurser kommer sökmotorerna ha att indexera andra delar av din webbplats.

Undvik att blockera viktiga sidor

När du skapar din robots.txt-fil är det viktigt att du inte blockerar viktiga sidor som kan påverka din sökmotoroptimering negativt. Exempel på sidor som du vill undvika att blockera är din startsida eller sidor som innehåller viktig information om ditt företag. Tänk noga igenom vilka sidor som är viktiga för dig att ha med i sökresultaten och se till att de inte blockeras av misstag.